Wenn ChatGPT lügt

Beachtlich, weil ja die ersten Redaktionen darüber nachdenken, Redakteure durch ChatGPT zu ersetzen.

Und für Blogsoftware gibt es ja auch schon Plugins, mit denen man sich per Mausklick einen Blogartikel schreiben lassen kann, wenn einem gerade nichts einfällt oder man keine Zeit oder keine Lust hat.

Vorhin wollte ich ein Detailproblem lösen. QR Codes in Ruby erzeugen. Das ist an sich kein Problem und trivial.

Nun wollte ich aber Micro QR Codes erzeugen, weil sie auf sehr kleine Aufkleber sollen, auf die normale QR-Codes nicht so passen, dass sie noch vernünftig zu drucken und zu scannen sind. Genau dafür hat man ja die Micro QR-Codes eingeführt. Dafür sind sie ja da.

Nun ist es grundsätzlich auch kein Problem, die zu erzeugen, denn das einschlägig bekannte Programm qrencode macht das. Man muss nur die Option -M angeben. Das ist alles.

Weil jetzt aber ganz viele davon gedruckt werden sollen und das nicht elegant und kein schöner Programmierstil ist, x-tausend Mal ein externes Programm als Unterprozess aufzurufen, hatte ich Google gefragt, ob eine der für Ruby verfügbaren Bibliotheken auch Micro QR Codes kann. Da muss man etwas aufpassen, weil manche nur ein Frontend für das Programm qrencode sind und man ja damit wieder genau das macht, was ich nicht will: Tausendmal ein externes Programm aufrufen. Geht schon, aber gefällt mir nicht.

Google meinte, bei Quora gäbe es Antwort und Erleuchtung.

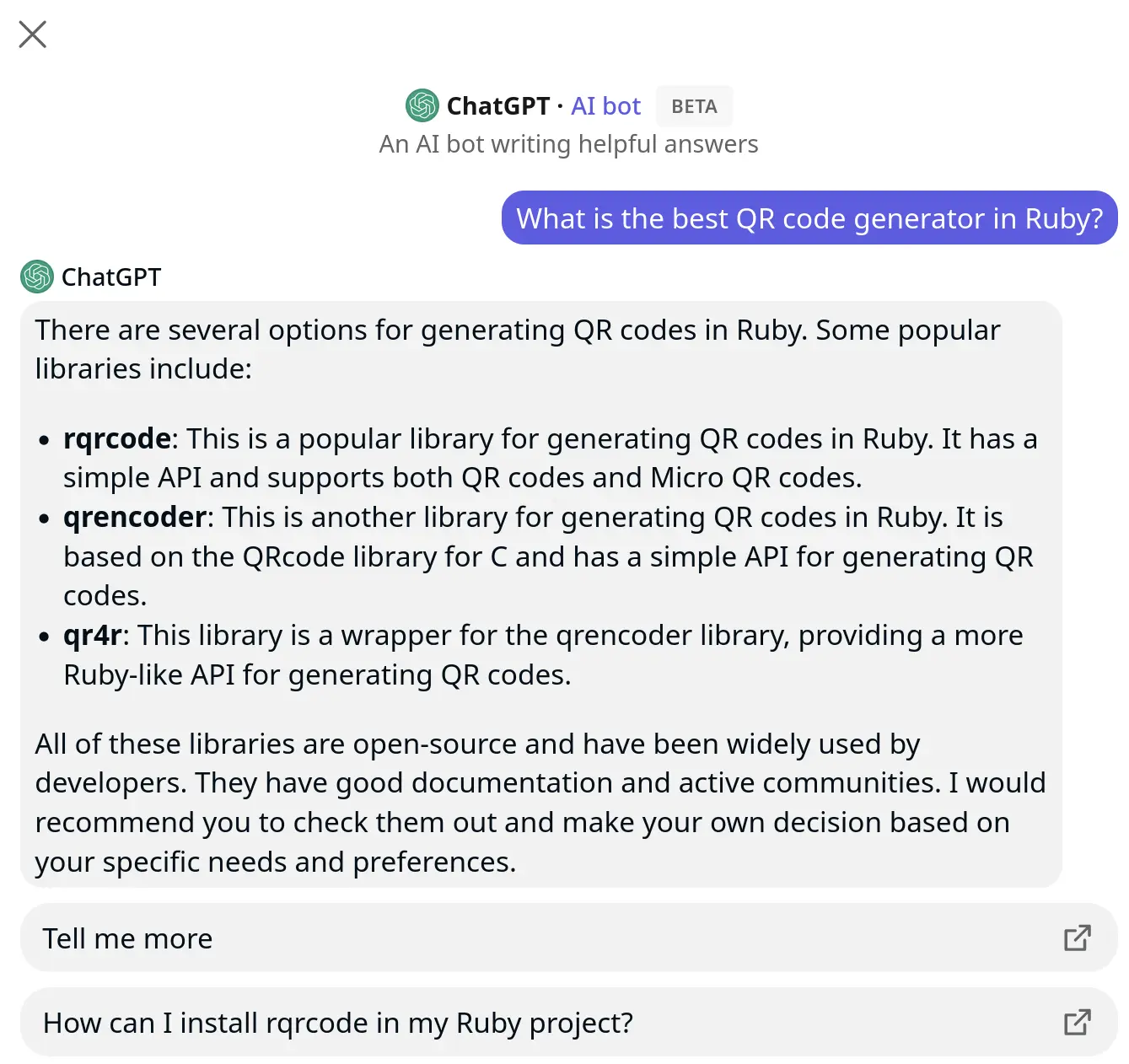

Und die Quora-Seite dort meint, die tollste Antwort auf die Frage sei die von ChatGPT:

Das steht ausdrücklich:

rqrcode has a simple API and supports both QR codes and Micro QR codes.

Nur: Stimmt nicht. Im README und Quelltext von rqrcode steht nichts davon. Ich habe den Maintainer gefragt und der meinte auch, geht nicht, stimmt nicht.

Wieder mal typisch: ChatGPT faselt einfach irgendwas, was so aussieht wie Texte, die es irgendwo gefunden hat, ohne den Sinn zu verstehen oder geprüft zu haben. Gerade hat irgendwo in den USA eine Anwaltskanzlei bösen Ärger, weil ein Anwalt einen Schriftsatz von ChatGPT hat erzeugen lassen und darin der Standpunkt auf drei Präzedenzurteile gestützt wird, wie das im US-Recht eben so üblich ist. Nur: Die drei Urteile gab es nicht, die hatte ChatGPT frei erfunden. Weil ChatGPT nicht versteht, dass diese Referenzen echte, existierende Urteile bezeichnen müssen, sondern nur lernt, wie diese Referenzen aussehen, als wären das rhetorische Bekräftigungen. ChatGPT lernt, dass wenn Anwälte Briefe an das Gericht schreiben, sie erst etwas ausführen, und das dann nochmal bekräftigen, indem sie es in dieser Form wiederholen, The People vs. Smith, Gericht irgendwas, blubber. Denkt sich, Anwälte reden so. Und ahmt das nach, ohne zu verstehen, dass das semantisch korrekt an ein Urteil anknüpfen muss. Denselben Effekt gab es ja auch schon bei wissenschaftlichen Texten, bei denen ChatGPT sich Fußnoten und Verweise ausdenkt, die es nicht gibt, weil es nur den Stil nachahmt.

Derselbe Denkfehler wie beim Cargo Cult: Das Nachahmen der äußeren Form ohne Verständnis der Funktion.

Bin mal gespannt, wann es den ersten ernsthaften Schaden durch so etwas gibt.